Dios será una inteligencia artificial

Advierten que la IA se está desarrollando sin ninguna clase de control y poniendo en riesgo la propia supervivencia de la humanidad

Seth Lazar, filósofo australiano y director del Laboratorio de Inteligencia de Máquinas y Teoría Normativa de la Universidad Nacional de Australia; y Alondra Nelson, presidenta del Consejo de Investigación de Ciencias Sociales de la Universidad de Columbia, han publicado un interesante artículo en la revista científica Science sobre los retos que debemos afrontar como consecuencia del rápido desarrollo de la inteligencia artificial (IA). Se preguntan cuestiones como las siguientes: «¿Qué significa hacer que los sistemas de IA sean seguros y qué valores y enfoques deben aplicarse para hacerlo? ¿Se trata simplemente de que la IA cumpla con la intención de algunos diseñadores? ¿O únicamente de prevenir la destrucción de la humanidad por parte de la IA avanzada?». En este sentido añaden: «Un sistema de IA capaz de aniquilar a la humanidad, incluso si logramos evitar que lo haga, seguiría estando entre las tecnologías más poderosas jamás creadas y tendría que cumplir con un conjunto mucho más rico de valores e intenciones».

Que la IA sea una amenaza para la supervivencia de nuestra especie es, únicamente, una cuestión de tiempo

Por fortuna, en la actualidad la IA está muy lejos de convertirse en una amenaza para la supervivencia de nuestra especie, pero únicamente es cuestión de tiempo. Mientras tanto, surgirán nuevos desarrollos que también van a constituir un riesgo, aunque no de ese calibre. El peligro está en que individuos y grupos poderosos utilicen el potencial de la IA para su propio beneficio. «Años de investigación sociotécnica muestran que las tecnologías digitales avanzadas, si no se controlan, se utilizan para obtener poder y ganancias a expensas de los derechos humanos, la justicia social y la democracia –escriben Seth Lazar y Alondra Nelson–. Hacer que la IA avanzada sea segura significa comprender y mitigar los riesgos para esos valores también».

RIESGO DE EXTINCIÓN

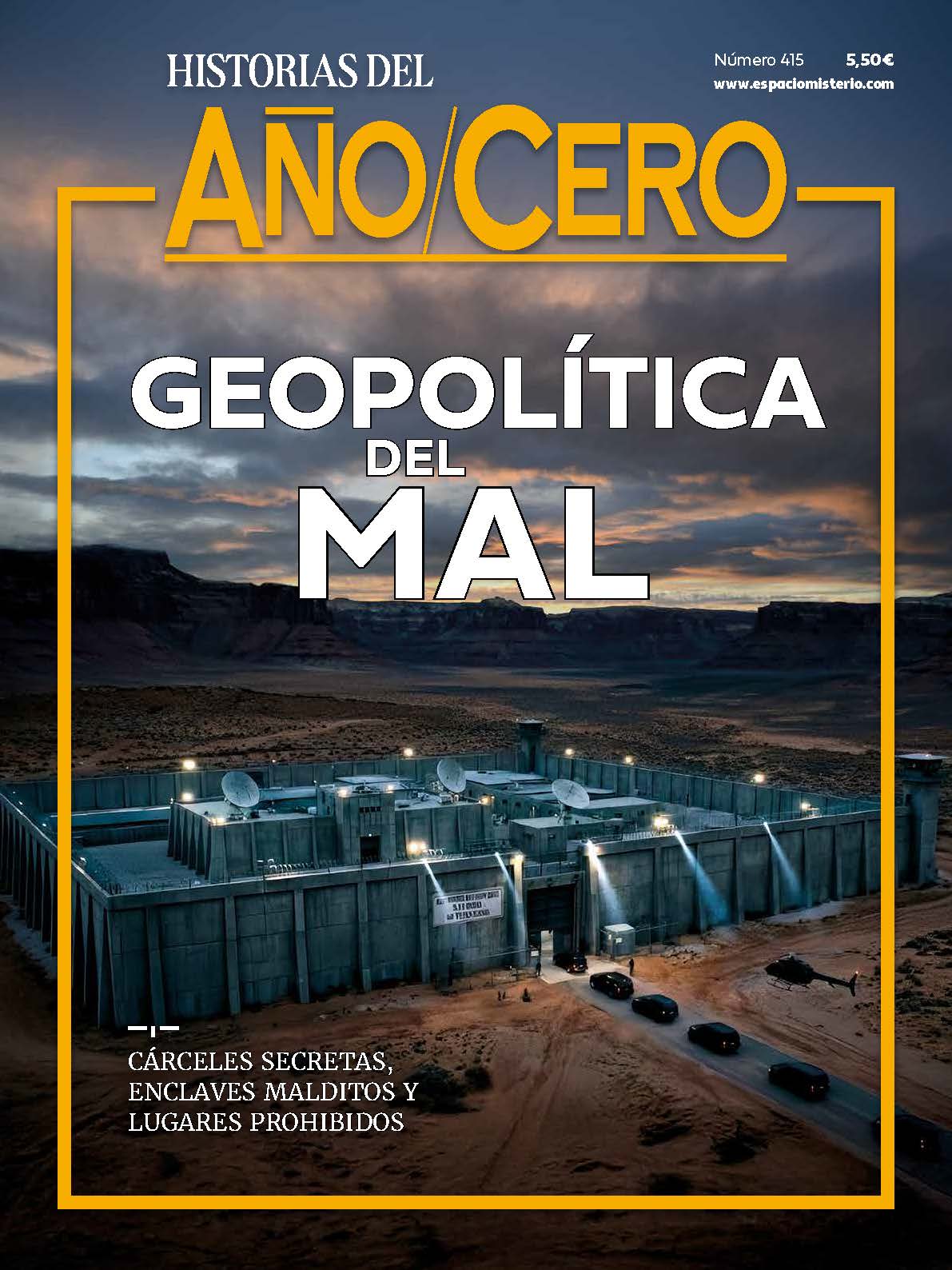

Además, ambos especialistas defienden que ningún grupo de expertos debe decidir unilateralmente sobre «qué riesgos cuentan, qué daños importan y en qué valores debe basarse una IA segura». De modo que se hace urgente «un debate público sobre todas estas preguntas y sobre si deberíamos intentar construir sistemas de IA ‘parecidos a Dios’». Del mismo modo, la seguridad de la IA no debe recaer exclusivamente en manos de los que la usan mayoritariamente, que son «desproporcionadamente blancos, hombres y favorecidos», en su mayoría vinculados a las empresas tecnológicas. Por último, advierten de un error que podemos cometer: «Ante un cambio tecnológico desorientador, la gente recurre instintivamente a los tecnólogos en busca de soluciones. Pero los impactos de la IA avanzada no pueden mitigarse solo con medios técnicos; las soluciones que no incluyan una visión social más amplia solo agravarán los peligros de la IA».

Desde luego, Lazar y Nelson no son los únicos expertos preocupados por el auge de la IA. Es el caso de Mo Gawdat, experto en IA y exdirector comercial de Google X –una organización semisecreta de investigación y desarrollo fundada por Google en enero de 2010–, quien ha llegado a recomendar a la gente que no tenga hijos, porque está convencido de que la IA acabará con la humanidad. Algunas semanas antes, 350 ejecutivos, investigadores e ingenieros expertos en esta tecnología firmaron una carta pública en la que advertían de que la IA supone un «riesgo de extinción» para la humanidad, al igual que catástrofes como una guerra nuclear o una pandemia.

El ex director comercial de Google X recomienda no tener hijos porque está convencido de que la IA acabará con la humanidad

Entre los firmantes se encuentran los máximos dirigentes de las principales empresas de IA: Sam Altman (presidente ejecutivo de OpenAI y máximo responsable del ChatGPT), Demis Hassabis (Google DeepMind) y Dario Amodei (Anthropic). Y también los investigadores Geoffrey Hinton y Yoshua Bengio, considerados los padres del movimiento moderno de IA. Hinton dejó hace unos meses Google, donde ocupaba una vicepresidencia, para dedicarse únicamente a advertir al público y a los líderes políticos de que esta tecnología puede llevarnos al fin de la civilización en cuestión de años.

«NI SUS CREADORES ENTIENDEN A LA IA»

En marzo de 2023, más de un millar de intelectuales, investigadores de la IA y empresarios del sector dieron a conocer un texto en el que solicitaban frenar durante «al menos seis meses» el desarrollo de sistemas de IA más poderosos que GPT4, la última versión de ChatGPT, puesto que esta herramienta de la empresa OpenAI ya es capaz de competir con los humanos en un buen número de tareas, y además se puede utilizar para destruir numerosos puestos de trabajo y difundir desinformación. En el citado texto, los expertos denuncian que no existe ninguna clase de regulación ni gestión sobre esta tecnología, «a pesar de que en los últimos meses los laboratorios de IA han entrado en una carrera sin control para desarrollar e implementar mentes digitales cada vez más poderosas que nadie, ni siquiera sus creadores, pueden entender, predecir o controlar de forma fiable».

Comentarios

Nos interesa tu opinión